Nvidia在GTC2022上推出了专为AI基础设施和高性能计算设计的全新GraceCPU超级芯片。基于ArmNeoverse的新型144核离散数据中心CPU实际上由两个CPU芯片组成,这些芯片通过公司的高速、低延迟、芯片到芯片(C2C)互连NVLink连接。

Nvidia的GraceCPUSuperchip补充了去年宣布的GraceHopperSuperchip,在一个载板上配备一个CPU和一个GPU。虽然它们的构成可能不同,但两个超级芯片共享相同的底层CPU架构以及NVLink-CNC互连。

Nvidia的创始人兼首席执行官JensenHuang在新闻稿中解释了GraceCPU超级芯片如何成为AI工作负载的理想选择,他说:

“一种新型的数据中心已经出现——处理和提炼大量数据以产生智能的人工智能工厂。GraceCPUSuperchip在一个芯片中提供最高性能、内存带宽和NVIDIA软件平台,并将作为世界人工智能基础设施的CPU大放异彩。”

为了推动下一波AI数据中心的发展,英伟达还宣布了采用NvidiaHoppper架构的下一代加速计算平台,该平台继承了公司两年前推出的NvidiaAmpere架构。

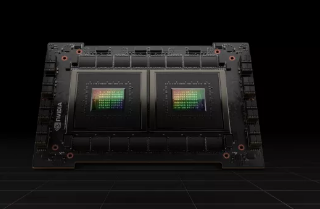

这家芯片制造商甚至宣布推出其首款基于Hopper的GPU,该GPU包含800亿个晶体管。NvidiaH100是迄今为止世界上最大、最强大的加速器,与GraceCPU超级芯片一样,它还具有NVLink互连功能,用于推进巨大的AI语言模型、深度推荐系统、基因组学和复杂的数字双胞胎。

对于需要更大功率的企业业务,Nvidia的DGXH100(其第四代DGX系统)具有8个H100GPU,可以以新的FP8精度提供32petaflops的AI性能。这提供了满足大型语言模型、推荐系统、医疗保健研究和气候科学的海量计算需求的规模。值得注意的是,Nvidia的DGXH100系统中的所有GPU都通过NVLink连接,以提供900GB/s的连接性。

该公司的全新Hopper架构已经获得领先云计算提供商的广泛行业支持,阿里云、AWS、百度人工智能云、谷歌云、微软Azure、甲骨文云和腾讯云都计划提供基于H100的实例。与此同时,思科、戴尔科技、HPE、浪潮、联想等系统厂商都在计划发布带有H100加速器的服务器。

Nvidia的H100GPU预计将于今年晚些时候在全球范围内从云服务提供商、计算机制造商以及直接从公司本身处获得。

标签:

版权声明:本文由用户上传,如有侵权请联系删除!